Was passiert eigentlich, wenn man ein Bild verlustfrei komprimiert? Um Daten zu komprimieren, muss man in den Daten wiederkehrende Muster finden. Daraufhin kann man diese speichersparend zusammenfassen. Also statt 10110 10110 10110 schreibt man beispielsweise kürzer 3 x 10110. Hiermit lässt sich in der Regel bereits einiges an Speicherplatz sparen.

Und wie funktioniert ein Large Language Model (LLM) à la ChatGPT? Hier versucht ein KI-Modell, die nächsten Worte in einer Wort-Sequenz zu erraten. GPT kann hiermit immer Sätze so weiterschreiben, wie sie höchstwahrscheinlich in einem Originaltext weitergeführt werden würden. Hierfür muss GPT ebenso Muster im vorgegebenen Text erkannt haben.

Mustererkennung und daraus eine Vermutung anzustellen, wie sich eine Datenfolge weiterentwickelt, verbindet somit die beiden Welten. Doch können große Sprachmodelle und effektive, verlustfreie Bildkompression in der Praxis wirklich viel miteinander zu tun haben?

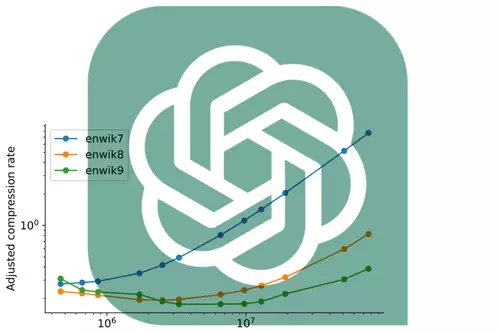

In dem arXiv-Forschungspapier mit dem Titel "Language Modeling Is Compression" legen Forscher nun einen solchen Zusammenhang nahe. So haben sie erstaunlicherweise entdeckt, dass das DeepMind LLM namens Chinchilla 70B eine verlustfreie Komprimierung von Bildpatches aus der ImageNet-Bilddatenbank auf 43,4 Prozent ihrer ursprünglichen Größe durchführen kann - und damit sogar den bewährten PNG-Algorithmus übertrifft, der dieselben Daten "nur" auf 58,5 Prozent komprimierte. Für Audio komprimierte Chinchilla Samples aus dem LibriSpeech-Audiodatensatz auf nur 16,4 Prozent ihrer Rohgröße und übertraf damit die übliche FLAC-Komprimierung mit 30,3 Prozent. In beiden Fällen handelt es sich um eine verlustfreie Komprimierung (lossless).

Das wirklich Seltsame an den überraschend guten Kompressions-Ergebnissen ist jedoch, dass Chinchilla 70B hauptsächlich für den Umgang mit Text trainiert wurde - und nun trotzdem überraschend effektiv bei der Komprimierung anderer Arten von Daten ist. In den zwei betrachteten Fällen sogar noch besser als Algorithmen, die speziell für diese Aufgaben entwickelt wurden. Damit dürfte wohl feststehen, dass KI-Modelle in Zukunft auch bei der Bild- und Audio-Kompression eine größere spielen werden.

Doch es gibt natürlich auch ein paar kritische Anmerkungen zu dieser Meldung, die gerade in IT- und KI-Kreisen große Wellen schlägt. Erstens ist das Paper noch nicht peer-reviewed, weshalb sich durchaus ein Fehler eingeschlichen haben könnte. So wäre denkbar, dass Chinchilla 70B bei seinem Training irgendwie Zugriff auf die ImageNet-Bilddatenbank sowie auf den LibriSpeech-Audiodatensatz hatte. Und damit die Daten schon durch das eigene Training kannte.

Zudem sollte man nicht die Größe des "Decoders" aus dem Auge verlieren. Um eine PNG-Datei zu dekomprimieren, reicht in der Regel ein sehr kleines Programm mit wenigen KB-Code aus, während ein Chinchilla 70B Modell als Decoder mehrere parallel geschaltete Hochleistungs-GPUs und hunderte GB GPU-RAM benötigt.

Solche KI-Kompressoren sind also keineswegs effizient bezüglich Speicherverbrauch oder Rechenleistung. Und werden es vermutlich auch nicht in absehbarer Zeit sein.